11-循环神经网络

回顾 DNN

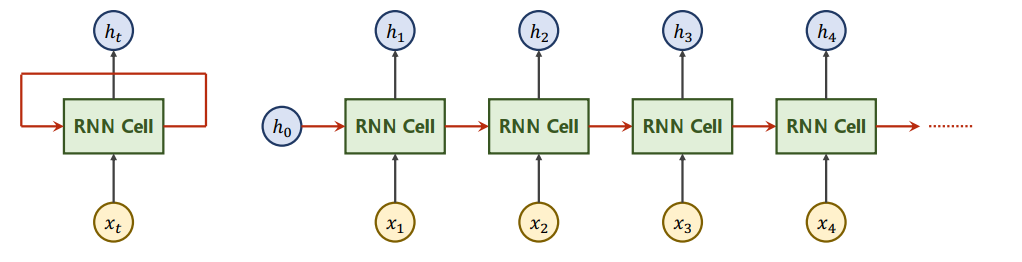

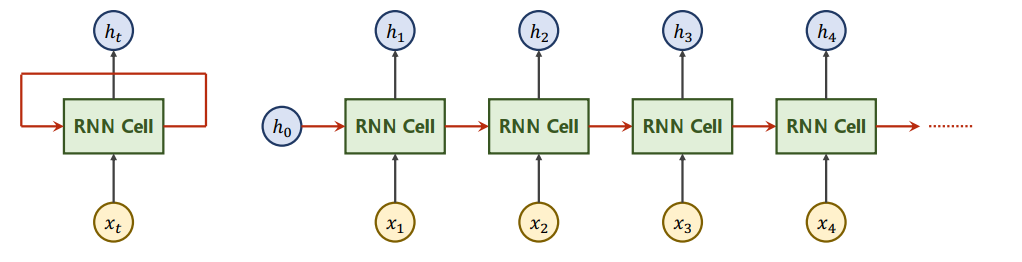

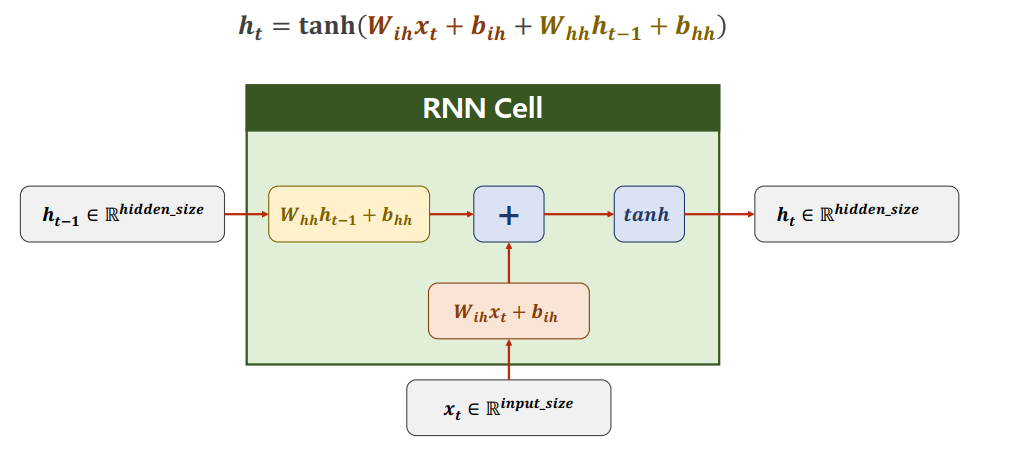

什么是RNN

RNN in Pytorch

调用RNN Cell

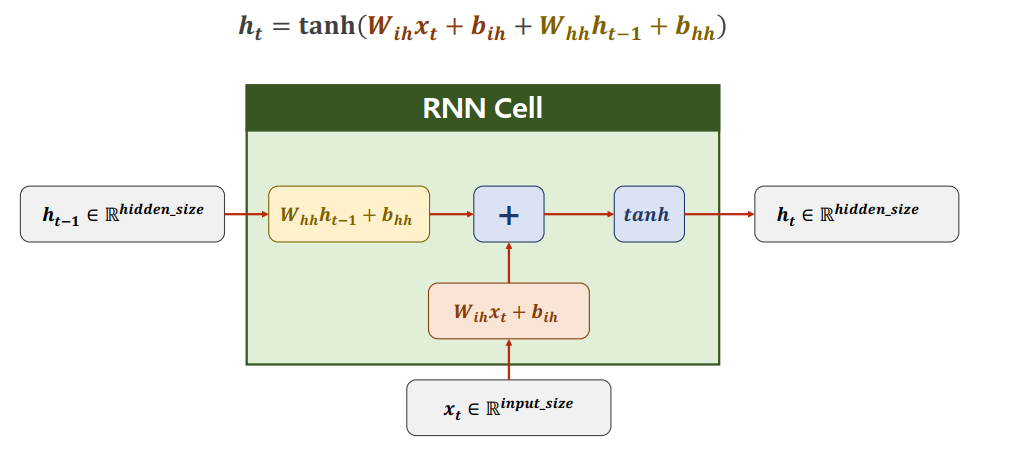

定义

如何使用RNN Cell

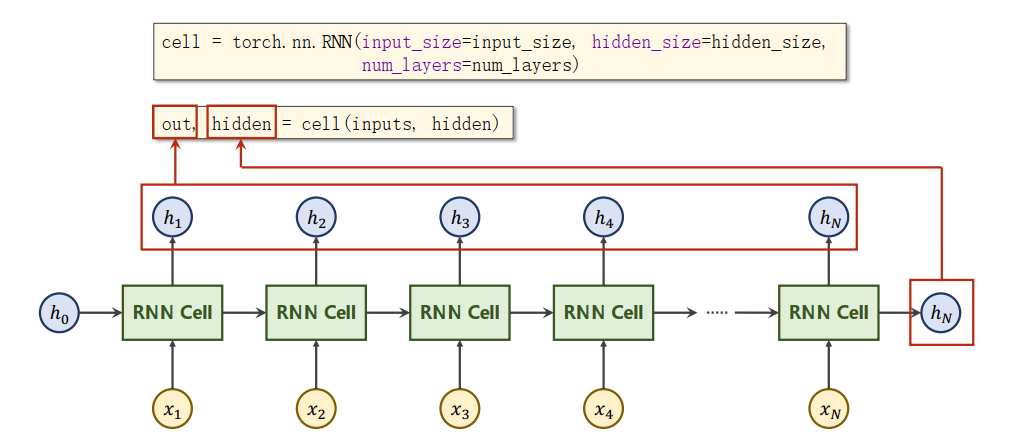

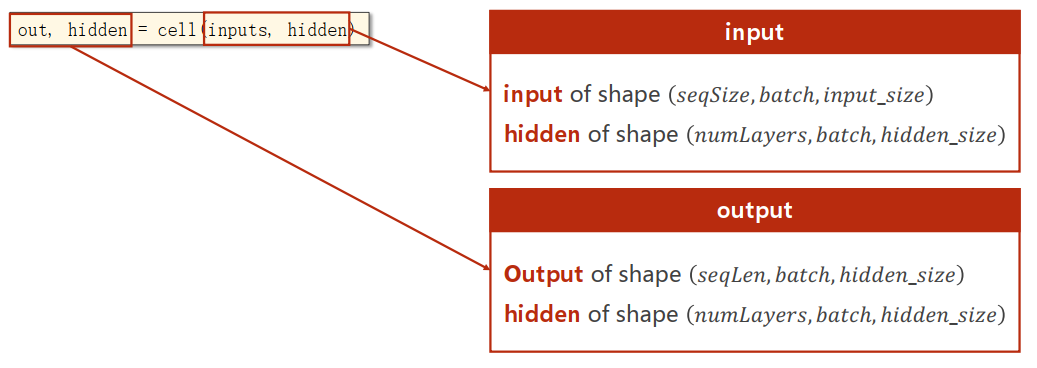

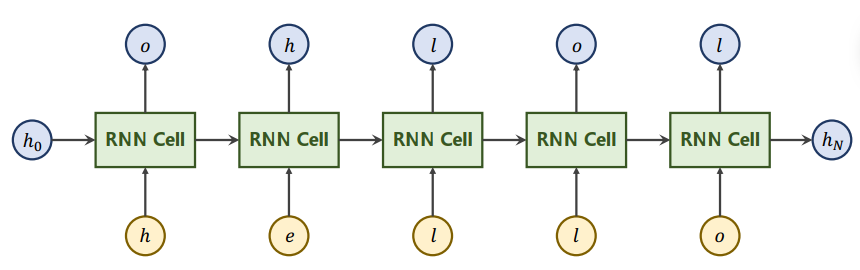

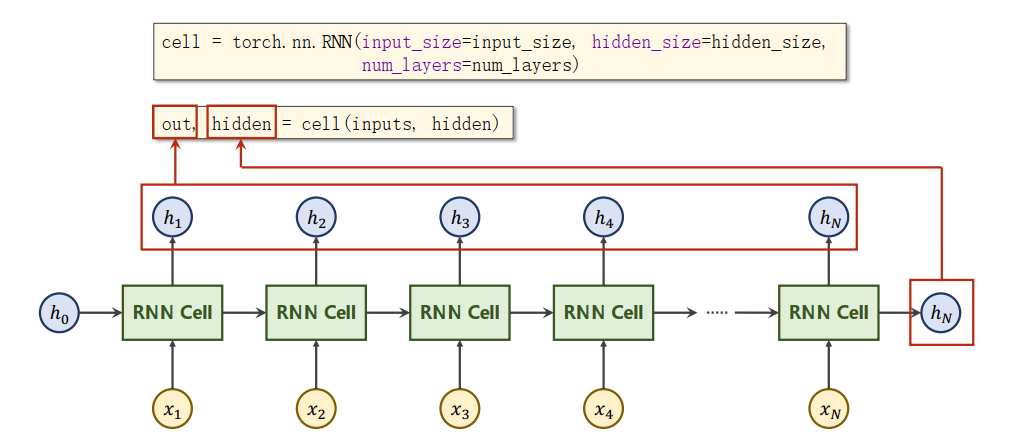

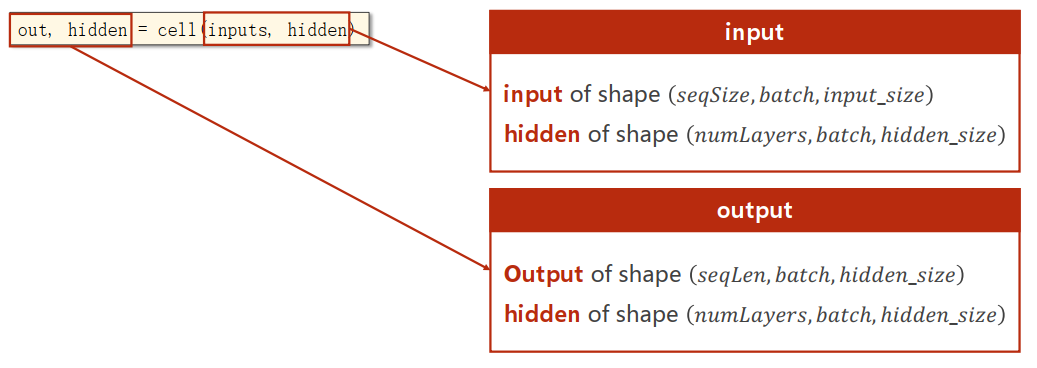

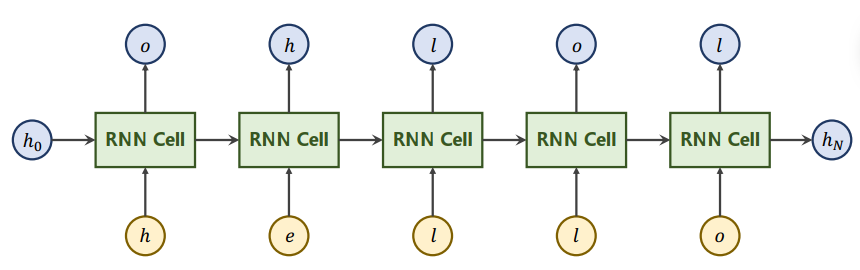

如何使用 RNN

实例

自定义RNN Cell

最后更新于

这有帮助吗?

最后更新于

这有帮助吗?

这有帮助吗?

linear = Linear()

h = 0

for x in X:

h = linear(x,h) => h1 = linear(x1,h0)

=> h2 = linear(x2,h1)

=> ...cell = torch.nn.RNNCell(input_size=input_size,hidden_size=hidden_size)

hidden = cell(input,hidden)import torch

batch_size = 1

seq_len = 3

input_size = 4

hidden_size = 2

cell = torch.nn.RNNCell(input_size=input_size,hidden_size=hidden_size)

dataset = torch.randn(seq_len,batch_size,input_size)

hidden = torch.zeros(batch_size,hidden_size)

for idx,input in enumerate(dataset):

print('='*20,idx,'='*20)

print('Inputs Size:',input.shape)

hidden = cell(input,hidden)

print('Outputs Size:',hidden.shape)

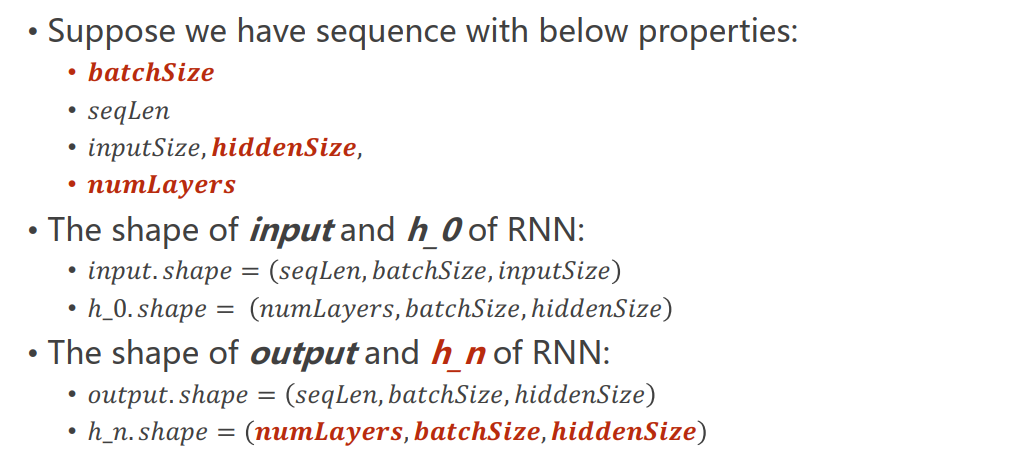

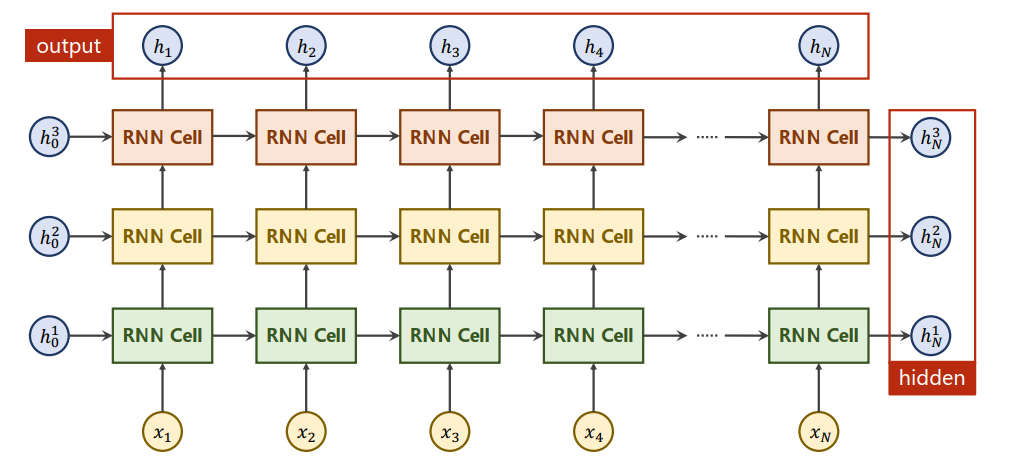

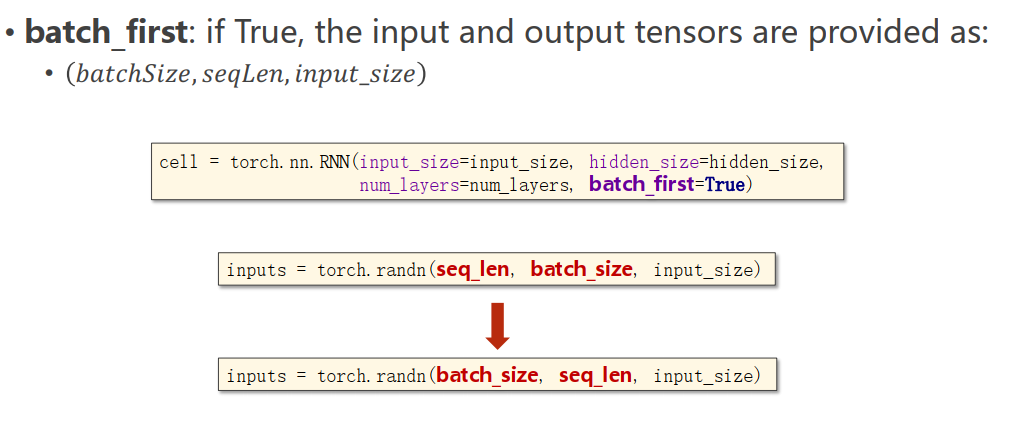

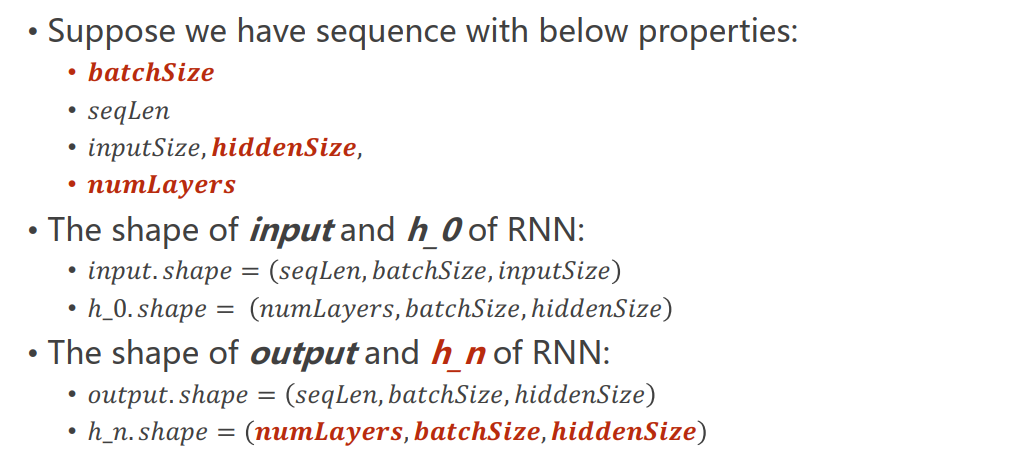

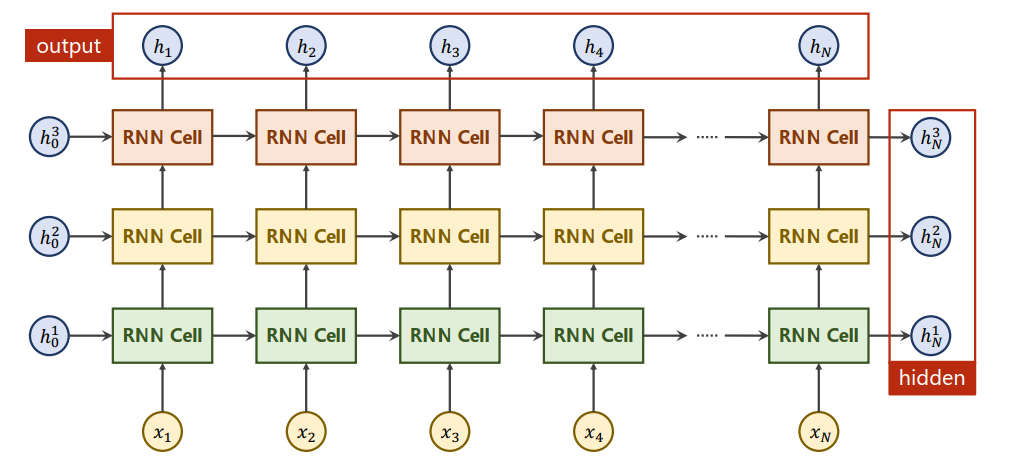

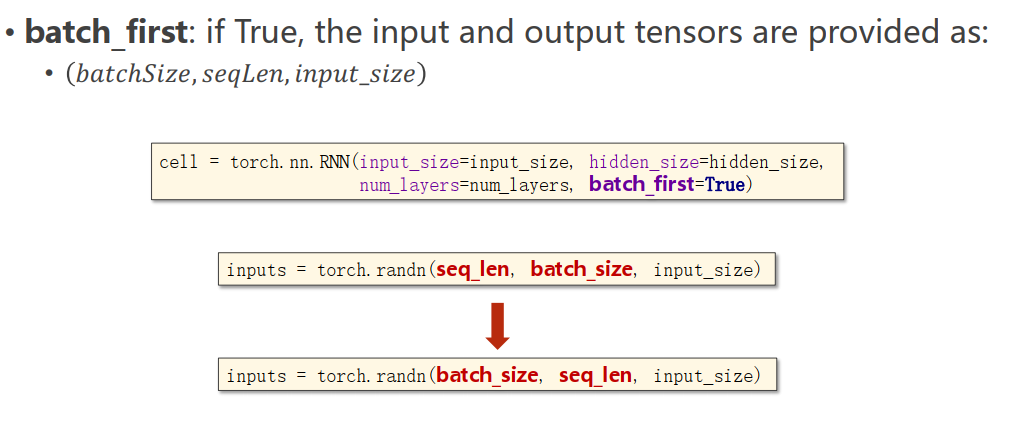

print(hidden)cell = torch.nn.RNN(input_size=input_size,hidden_size=hidden_size,num_layers=num_layers)

out,hidden = cell(inputs,hidden)import torch

batch_size = 1

seq_len = 3

input_size = 4

hidden_size = 2

num_layers = 1

cell = torch.nn.RNN(input_size=input_size,

hidden_size=hidden_size,

num_layers=num_layers)

inputs = torch.randn(seq_len,batch_size,input_size)

hidden = torch.zeros(num_layers,batch_size,hidden_size)

out,hidden = cell(inputs,hidden)

print("Output Size:",out.shape)

print("Output:",out)

print("Hidden Size:",hidden.shape)

print("Hidden:",hidden)